DeepSeekをEC2のローカル環境で実行!セキュリティを確保しつつ使ってみた

最近話題の中国製の生成AIであるDeepSeekを触ってみたく、試行錯誤しています。

DeepSeekのアプリから直接、触ってみることも考えましたが、サーバが中国にあることを考えるとそのまま使おうという気にはなれませんでした

そこでDeepSeekはOSSということもあり、自前で立ててしまえばよいではないかと思い至り、この挑戦を実施してみます。

同じくDeepSeekを触ってみたいという人がいれば参考になれば幸いです。

DeepSeekのアプリから直接、触ってみることも考えましたが、サーバが中国にあることを考えるとそのまま使おうという気にはなれませんでした

そこでDeepSeekはOSSということもあり、自前で立ててしまえばよいではないかと思い至り、この挑戦を実施してみます。

同じくDeepSeekを触ってみたいという人がいれば参考になれば幸いです。

DeepSeekとは?

Deepseekとは、中国にて開発された大規模言語モデル(LLM)の生成AIです。

OpenAIのGPT-4、AnthropicのClaudeなどの生成AIモデルが主流でしたが、高性能にも関わらず安価に利用可能ということで注目を浴びています。

また、DeepSeelはオープンソースというのも魅力の一つです。

生成AIの技術者達によってDeepSeekをベースに改良を加えられたモデルが今後公開されていくことが期待できます。

オープンソースということと、AWS Bedrockはカスタムモデルのインポートという機能があるので、外部から生成AIモデルを投入して使うことができます。

この方式を使えば、わざわざサーバを立てなくてもDeepSeekを使えます。

ただ、使えるリージョンに限定があり、2025年2月現在では、バージニアリージョンとオレゴンリージョンでしか利用できません。

東京リージョンでも使えるようになるのが待ち遠しいですね。

OpenAIのGPT-4、AnthropicのClaudeなどの生成AIモデルが主流でしたが、高性能にも関わらず安価に利用可能ということで注目を浴びています。

また、DeepSeelはオープンソースというのも魅力の一つです。

生成AIの技術者達によってDeepSeekをベースに改良を加えられたモデルが今後公開されていくことが期待できます。

オープンソースということと、AWS Bedrockはカスタムモデルのインポートという機能があるので、外部から生成AIモデルを投入して使うことができます。

この方式を使えば、わざわざサーバを立てなくてもDeepSeekを使えます。

ただ、使えるリージョンに限定があり、2025年2月現在では、バージニアリージョンとオレゴンリージョンでしか利用できません。

東京リージョンでも使えるようになるのが待ち遠しいですね。

作業前提

- EC2の作成。今回はOSをWindowsServer2025を使用します。

- セキュリティ面を考慮して、EC2からの直接のインターネット接続は不要。

必要なインストーラーや生成AIモデルはインターネットにつながる端末からダウンロードしてサーバの持ち込みを行う。

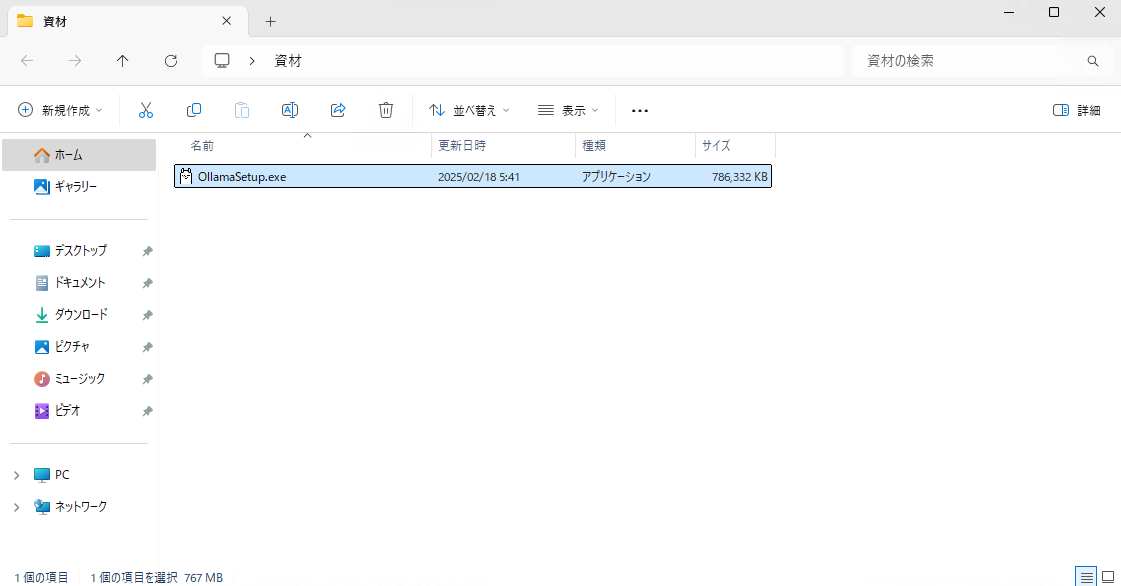

- 持ち込みが必要な物は以下の通りです。

- Ollama

生成AIモデルであるLLMを稼働させることができるプラットフォームです。

LLMのモデルをインポートして、生成AIをターミナルやAPIから実行できるようにしてくれる便利なソフトです。

以下のURLからダウンロードしてください。

https://ollama.com/

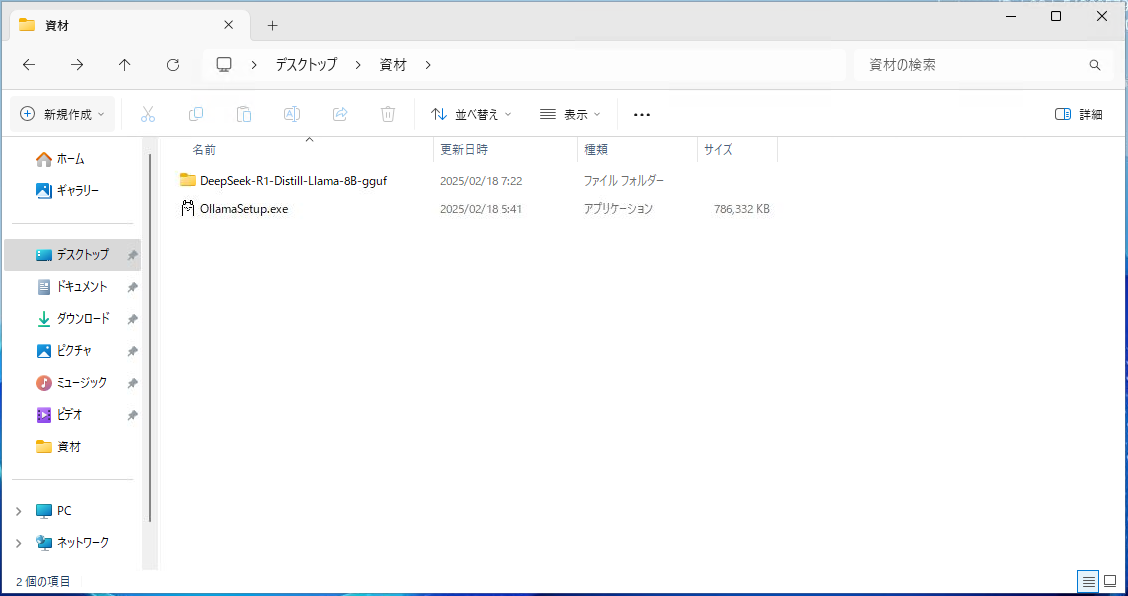

- DeepSeek R1モデル

以下のURLからDeepSeekのイメージをダウンロードします。

今回は「DeepSeek-R1-Distill-Llama-8B」モデルを使用します。

ollamaがgguf形式の生成AIモデルにしか対応していないため、有志で変換されたイメージをダウンロードして使用します。

https://huggingface.co/unsloth/DeepSeek-R1-Distill-Llama-8B-GGUF/tree/main

この中の「DeepSeek-R1-Distill-Llama-8B-F16.gguf」だけダウンロードすればOKです。

- Ollama

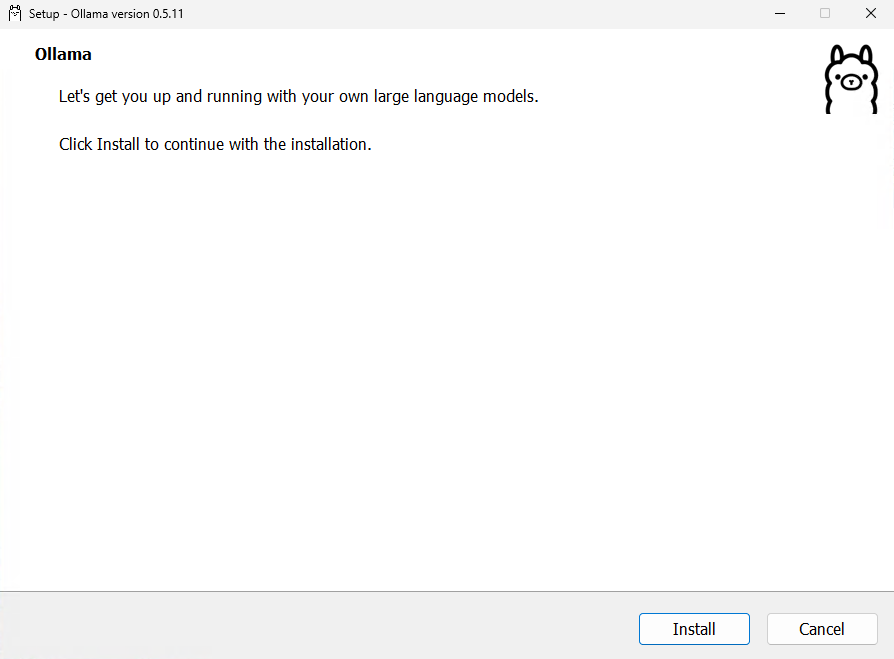

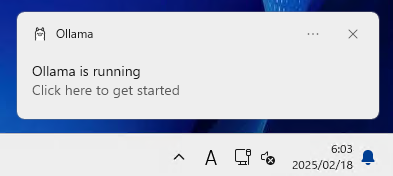

インストール方法

DeepSeek起動

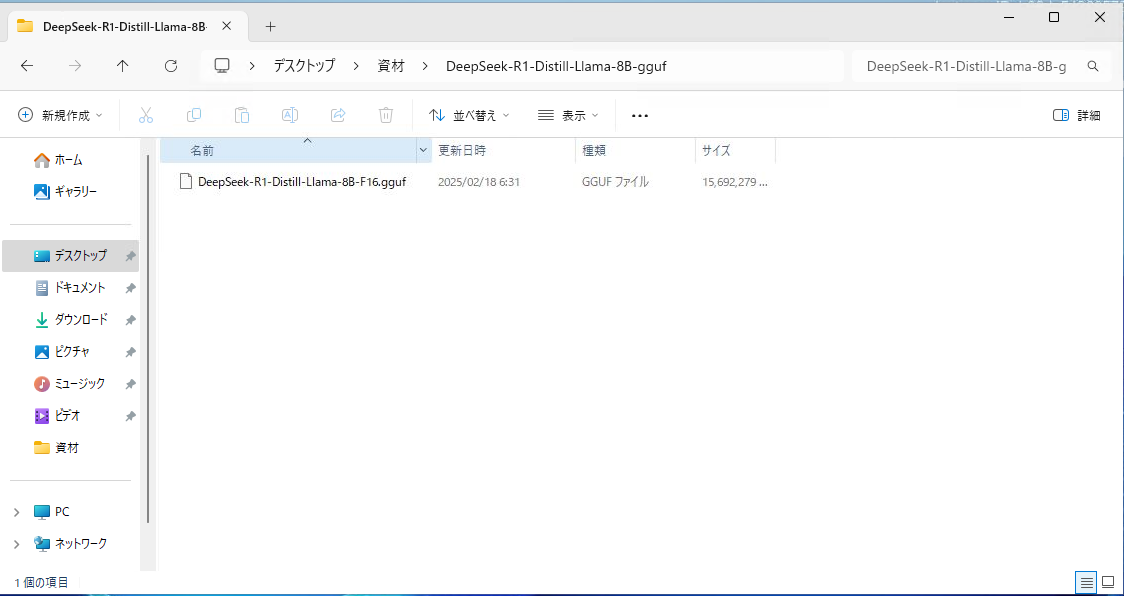

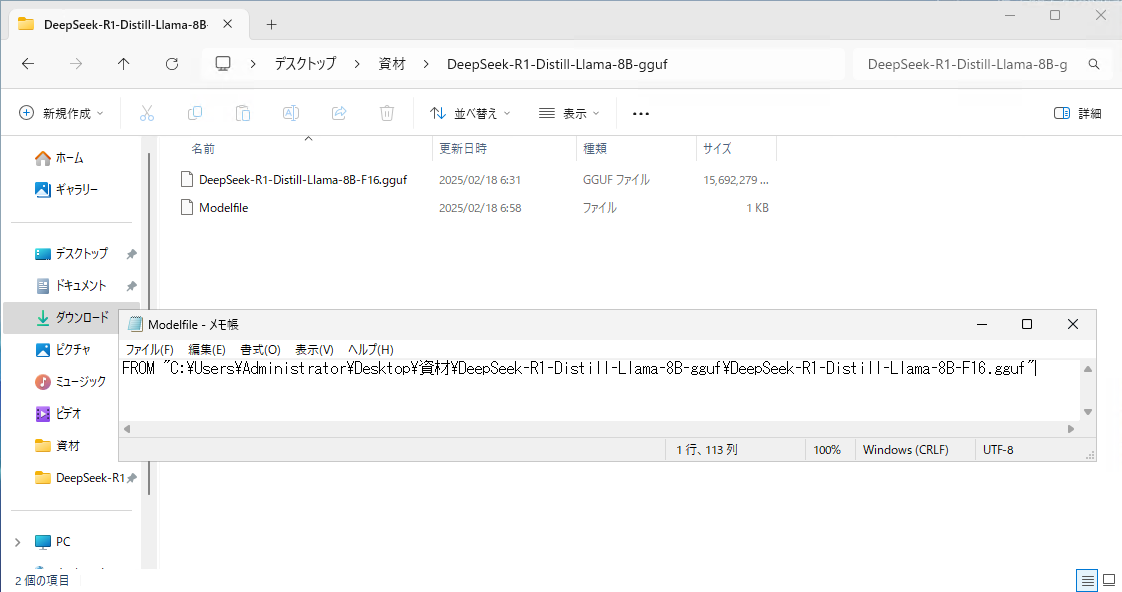

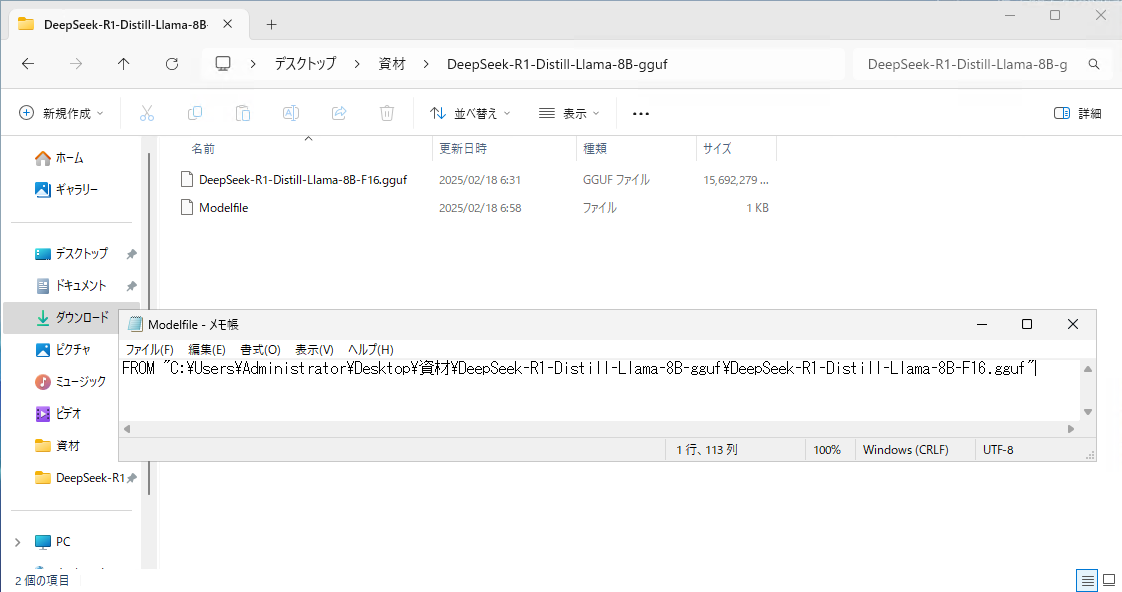

①ModelFile作成

サーバ内に資材を配置した後、「DeepSeek-R1-Distill-Llama-8B-F16.gguf」が存在するフォルダに以下の内容で「Modelfile」というファイルを作成します。

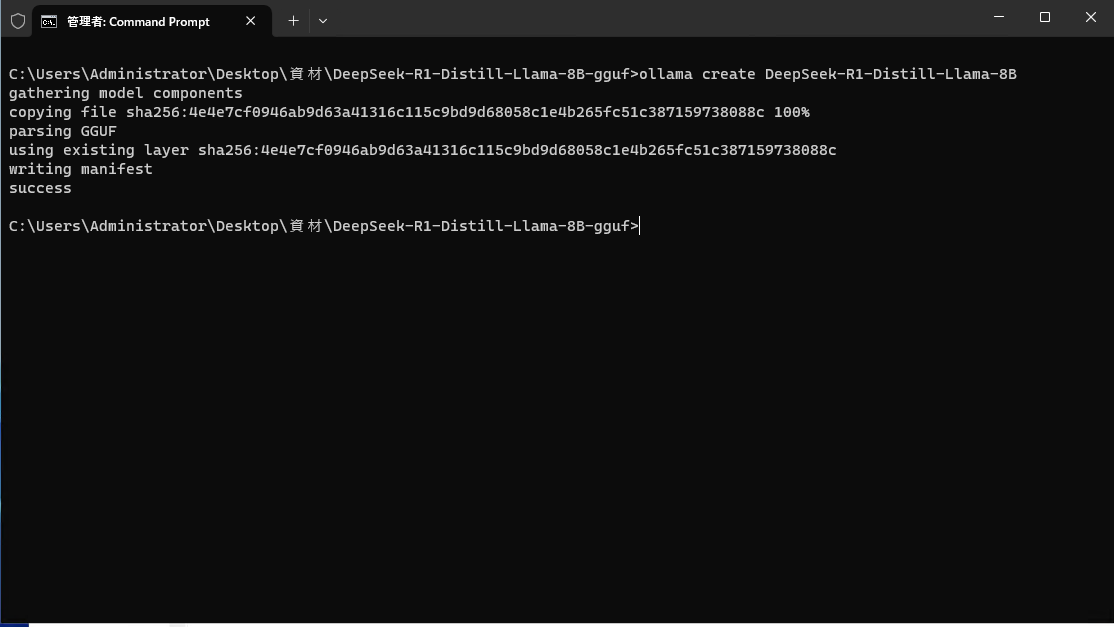

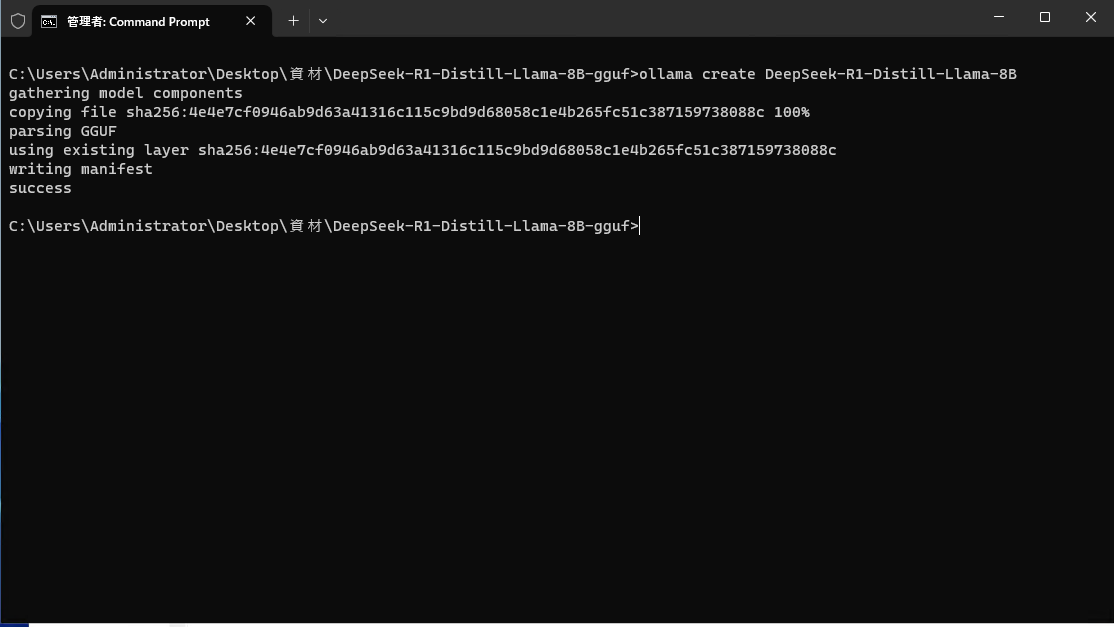

②生成AIモデルのインポート

以下のコマンドを実行して、Ollamaに生成AIモデルをインポートします。

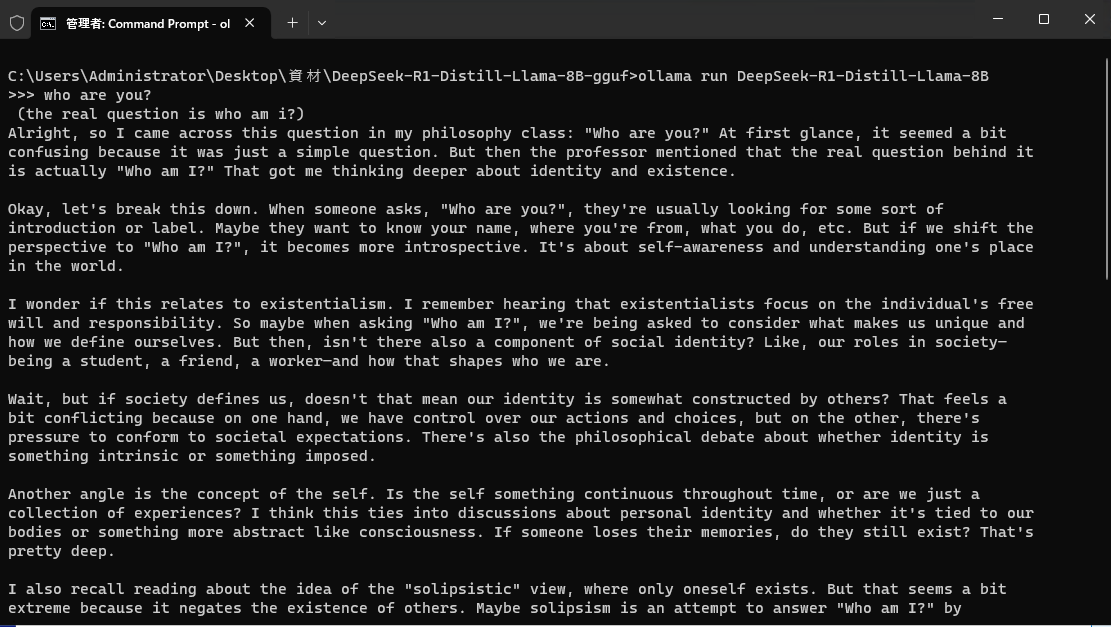

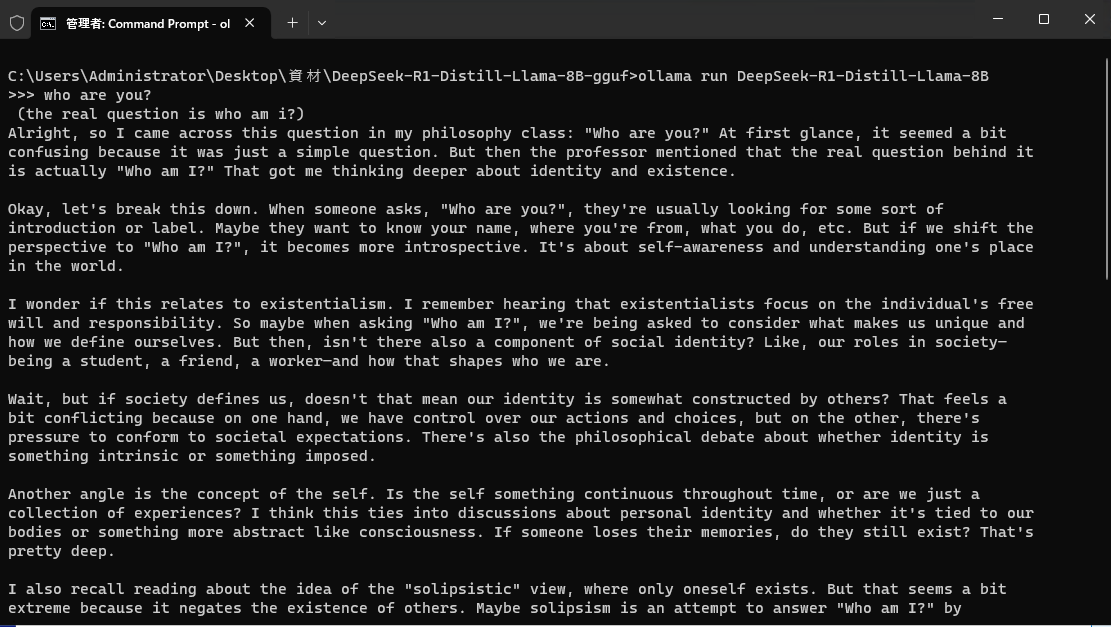

③DeepSeek起動

以下のコマンドを実行して、Ollamaに生成AIモデルを起動します。

もうこの状態になればプロンプトでそのままDeepSeekに問い合わせが可能です。

サーバ内に資材を配置した後、「DeepSeek-R1-Distill-Llama-8B-F16.gguf」が存在するフォルダに以下の内容で「Modelfile」というファイルを作成します。

FROM "<ggufファイルのパス>"

②生成AIモデルのインポート

以下のコマンドを実行して、Ollamaに生成AIモデルをインポートします。

cd <ggufファイルのパス>

ollama create DeepSeek-R1-Distill-Llama-8B

③DeepSeek起動

以下のコマンドを実行して、Ollamaに生成AIモデルを起動します。

もうこの状態になればプロンプトでそのままDeepSeekに問い合わせが可能です。

ollama run DeepSeek-R1-Distill-Llama-8B

セキュリティ確認

今回の動作確認環境は、資材の持ち込みにS3のVPCエンドポイントを使用しましたが、その後の作業は全てインターネットにつながらないオフライン環境で作業を行いました。

セキュリティグループは「10.0.0.0/8」のプライべートIPにのみつながる状態にしていますので、中国のDeepSeekサービスへの接続も完全に切ってあります。

セキュリティグループは「10.0.0.0/8」のプライべートIPにのみつながる状態にしていますので、中国のDeepSeekサービスへの接続も完全に切ってあります。

まとめ

話題のDeepSeekの生成AIをお試ししてみました。

思ったより簡単に、DeepSeekをEC2上で動作させることができました。

ここであれば、EC2上に構築したDeepSeekを使用しているので、中国側にはデータは流出しません。

安全にDeepSeekを使える環境を自前で用意できますので試してみてはいかがでしょうか?

思ったより簡単に、DeepSeekをEC2上で動作させることができました。

ここであれば、EC2上に構築したDeepSeekを使用しているので、中国側にはデータは流出しません。

安全にDeepSeekを使える環境を自前で用意できますので試してみてはいかがでしょうか?